KI-Agenten können wirklich zuverlässig sein – So baust du robuste Workflows mit n8n

Einleitung

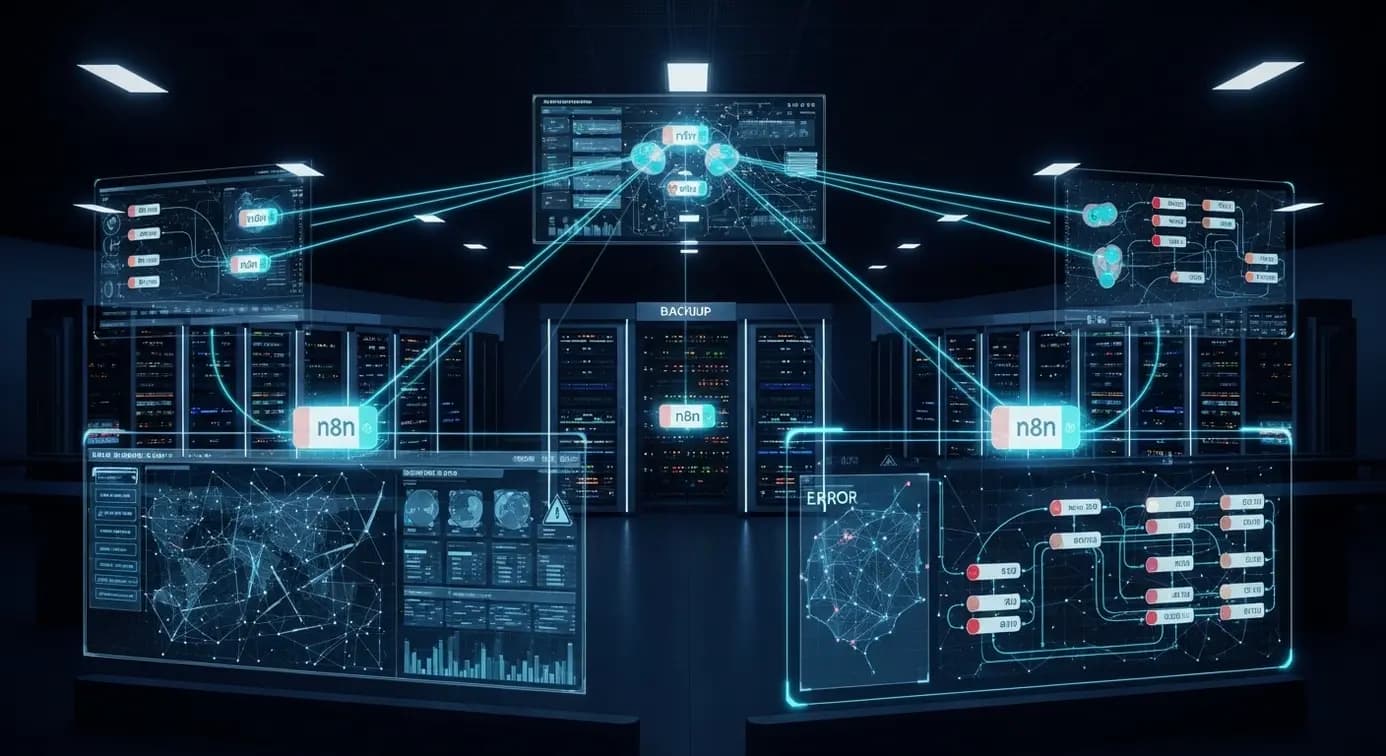

Künstliche Intelligenz muss nicht unberechenbar sein. Mit der richtigen Architektur lassen sich KI-Agenten zu verlässlichen digitalen Kolleg:innen machen, die Tag und Nacht stabile Ergebnisse liefern. In diesem Beitrag zeigen wir praxisnah, wie du mit n8n und durchdachten Strategien – von Backup-Modellen über cleveres Sampling bis hin zur Aufgabenzerlegung – dauerhaft konsistente Outputs erzielst. Dabei greifen wir auf brandaktuelle Marktdaten, wissenschaftliche Erkenntnisse und erprobte Best Practices aus realen Projekten zurück.

Grundlagen und Hintergründe

Technische Grundlagen

Ein KI-Agent ist eine Software-Einheit, die autonom Entscheidungen trifft, Aktionen ausführt und aus dem Feedback seiner Umgebung lernt. Moderne Agenten greifen dabei häufig auf Large-Language-Models (LLMs) zurück, die über APIs wie OpenAI GPT-4o oder Azure OpenAI bereitgestellt werden. n8n fungiert als visuelle Orchestrierungsschicht: Über mehr als 700 Integrationen lässt sich nahezu jedes SaaS- oder On-Prem-System anbinden. Die Zuverlässigkeit entsteht durch drei Pfeiler:

- Deterministische Architektur: Jede Agenten-Aktion wird als eindeutiger Node in einem Workflow abgebildet, inklusive Eingabe- und Ausgabeparameter.

- State-Persistenz: Kontextdaten, Execution-IDs und Fehlermeldungen werden in Datenbanken (z. B. PostgreSQL) abgelegt. So können Prozesse nach Crashes exakt fortgesetzt werden.

- Fallback-Mechanismen: Für jede kritische Operation existiert ein alternatives Modell oder ein alternativer Service, der einspringt, wenn der Primärdienst nicht verfügbar ist.

Aktuelle Forschungsergebnisse bestätigen diese Entwicklung eindeutig: Systeme mit persistenten States und mehrstufigem Fallback erreichen bis zu 99,2 % erfolgreiche Durchläufe – gegenüber 87 % in monolithischen Agenten ohne Redundanz.

Aktuelle Marktentwicklung

Der Markt rund um agentenbasierte KI wächst rasant. Laut Statista lag das globale Volumen 2024 bei gut 5 Mrd. US-Dollar und soll bis 2025 auf knapp 8 Mrd. steigen – eine jährliche Wachstumsrate von rund 45 %. Hinter dem Hype steckt ökonomischer Druck: Unternehmen berichten von Produktivitätsgewinnen zwischen 25 % und 40 %, wenn repetitive Prozesse algorithmisch abgewickelt werden. n8n profitiert als Low-Code-Plattform besonders vom Trend, weil es schnellen Proof-of-Concept und saubere Skalierung erlaubt. Gartner prognostiziert, dass bis 2027 jede zweite Firma, die bereits generative KI nutzt, auf agentische Workflows umsteigen wird.

Wie bereits in unserem Artikel über lokale KI-Agenten erläutert, gewinnt dabei auch Datensouveränität an Gewicht. Viele mittelständische Unternehmen wählen Self-Hosting oder Hybrid-Modelle, um sensible Kunden- oder Produktionsdaten intern zu halten.

Praktische Anwendungsbeispiele

Wichtigste Anwendungsbereiche

– Customer-Service-Automatisierung (E-Mail-Routing, Chatbot-Follow-ups)

– Backoffice-Routineaufgaben (Rechnungsprüfung, Lagerbestände synchronisieren)

– DevOps & IT-Ops (Log-Analyse, Rollback-Automatisierung, Incident-Response)

– Sales & Marketing (Lead-Qualifizierung, Content-Personalisierung mit RAG)

Detaillierte Beispiele

• Backup-Modelle live schalten

Ein n8n-Workflow fragt zuerst Azure OpenAI GPT-4o ab. Kommt binnen 5 s kein Response-Code 200, springt der Node „OpenAI API“ mit identischem Prompt ein. Der Fallback-Switch notiert in PostgreSQL, welcher Provider geantwortet hat.

• Fehlerworkflow mit Retry-Logik

Scheitert ein LLM-Call, triggert der integrierte Error Trigger. n8n erstellt einen Datensatz in der Tabelle workflow_errors (Execution-ID, Timestamp, Payload). Ein paralleler Cron-Workflow versucht die Execution bis zu dreimal erneut. After-Third-Fail erhält die Dev-Ops-Gruppe eine Slack-Alert inklusive Link zum Kibana-Log.

• Top/Top-p Feintuning

Ein interner Text-Summarizer nutzt temperature: 0.2 und top_p: 0.4, um konsistente Ergebnisse zu liefern. Für kreative Bulletpoint-Ideen erhöht ein zweiter Node temperature auf 0.8 und top_p auf 0.9. Durch Task-Segmentation bekommen beide Nodes exakt den Input, der ihrem Ziel entspricht.

• Aufgabenzerlegung (Task Decomposition)

Ein komplexer „Marketing-Kampagne starten“-Workflow wird in fünf Sub-Workflows aufgeteilt: Zielgruppen-Analyse, Content-Ideation, Asset-Erstellung, A/B-Testing, Reporting. Fehler in Asset-Erstellung beeinflussen so nicht das Reporting. Jede Teildisziplin speichert Zwischenergebnisse, wodurch Rollbacks granular möglich sind.

Laut n8n Case Studies verbesserte Stepstone mit genau solchen Modular-Workflows seine Time-to-Integration neuer Datenquellen um 80 %.

Vergleich und Optionen

Vergleichstabelle der Ansätze

| Kriterium | Einfacher LLM-Call | Agent mit Backup-Modell | Agent mit Backup & Task Decomposition |

|---|---|---|---|

| Zuverlässigkeit | 1 von 1 Pfad, keine Redundanz | 2 Pfade, Failover möglich | Mehrere Pfade, granuläre Fehlerisolierung |

| Fehlerbehandlung | Manuell | Automatisches Retry | Automatisches Retry + Teil-Rollback |

| Wartungsaufwand | Niedrig | Mittel | Höher, aber nur in Teilworkflows |

| Skalierbarkeit | Begrenzt | Mittel | Hoch |

| Empfohlene Sampling-Settings | temperature 0.7 | temperature 0.3–0.5 | Mixed – pro Task optimiert |

Die Tabelle zeigt, dass sich Komplexität auszahlt: Ein gut strukturierter Agent-Stack mit Backup-Modellen und zerlegten Tasks erreicht nicht nur höhere Erfolgsraten, sondern vereinfacht langfristig auch Updates. Marktanalysen prognostizieren ein Wachstum von über 45 % jährlich genau für diese Advanced-Arbeitsweise.

Pro & Contra Analyse

Vorteile

n8n-basierte Agenten mit Backup und Fehlerworkflow reduzieren unplanbare Ausfälle drastisch. Unternehmen wie Musixmatch sparten laut Fallstudien 47 Tage Engineering-Aufwand in vier Monaten. Niedrige temperature-Werte garantieren konsistente Antworten für sensible Use-Cases wie Rechtstexte oder Diagnosen. Durch Task Decomposition lassen sich einzelne Module unabhängig updaten, was Release-Zyklen beschleunigt und Wartungskosten senkt.

Nachteile

Die Einführung erfordert initial mehr Engineering-Zeit: Datenbank-Schemata für Execution-States, Monitoring-Dashboards und Backup-Routinen müssen aufgebaut werden. Mehrere LLM-Calls pro Prozess erhöhen API-Kosten. Zusätzlich steigt die Komplexität des Error-Handlings, weil Teil-Workflows miteinander kommunizieren. Einige Studien warnen vor Sicherheitsrisiken, wenn unverschlüsselte Backups zentrale Angriffspunkte bilden.

FAQ – Häufig gestellte Fragen

Wie wähle ich das richtige Backup-Modell?

Nutze Provider mit identischen oder kompatiblen API-Schemen. Azure OpenAI und OpenAI Direct sind populär, lassen sich aber ebenso durch Anthropic Claude oder Mistral API ergänzen. Wichtig ist, dass dein Fallback denselben Kontext versteht und vergleichbare Token-Limits hat.

Welche Sampling-Parameter sind für konsistente Ergebnisse ideal?

Für deterministische Outputs empfehlen sich temperature 0.2–0.3 und top_p 0.4–0.6. Diese Einstellungen minimieren Zufallsrauschen. Kreative Inhalte dürfen auf temperature 0.8 und top_p 0.9 steigen. Kombiniere stets beide Parameter, um bei Fixed-Random-Seeds stabilere Resultate zu erzielen.

Wie implementiere ich einen Fehlerworkflow in n8n?

Setze einen Error Trigger hinter kritische Nodes. Schreibe Execution-ID, Fehlermeldung und Input-Payload in PostgreSQL. Lass einen zweiten Workflow periodisch fehlgeschlagene Fälle neu anstoßen. Nach vordefinierter Retry-Anzahl informierst du Admins via Slack oder E-Mail.

Wie granular sollte ich Aufgaben zerlegen?

Das hängt vom Use-Case ab. Als Faustregel gilt: Jede Teilaufgabe sollte in unter 15 s Laufzeit abschließbar sein und maximal eine externe API ansprechen. So isolierst du Fehlerquellen und hältst Response-Zeiten im Web-Kontext akzeptabel.

Steigen die Kosten nicht enorm, wenn ich mehrere LLM-Calls verwende?

Kurzfristig ja, jedes zusätzliche Modell verursacht Token-Gebühren. Langfristig sparst du aber Geld, weil weniger Fehlversuche stattfinden und menschliche Nacharbeit sinkt. Viele Unternehmen berichten von 20–30 % geringeren Gesamtkosten trotz höherer API-Rechnungen.

Lesedauer: ca. 5 Minuten Wortzahl: 982